Martedì scorso (8 giugno) moltissimi siti Internet sono diventati inaccessibili per circa un’ora: siti governativi, Amazon, Reddit, Twitch, Hulu, PayPal, Vimeo e molte testate giornalistiche.

Alcuni giornali hanno parlato frettolosamente di attacco hacker, senza alcuna prova a sostegno, per poi correggere il tiro. La ragione reale, infatti, è stata molto, molto più banale.

Incredibilmente banale: il collasso è stato causato da una singola azienda, Fastly, che è andata a gambe all’aria. Già questo è imbarazzante, ma non è finita: Fastly è crollata per colpa di un singolo utente.

Sul serio: un utente di Fastly ha cambiato le proprie impostazioni, ed è venuta giù buona parte di Internet. Come è possibile?

Fastly è un fornitore statunitense di edge cloud o cloud perimetrale: un servizio che rende più veloce il caricamento dei siti, li protegge contro gli attacchi informatici e li aiuta quando ci sono picchi di traffico da parte di visitatori. È uno di una rosa piuttosto ristretta, che include nomi come Amazon Web Services e Cloudflare. Praticamente tutti i siti Internet si appoggiano a questi fornitori, per cui l’idea che Internet sia in grado di sopportare un attacco nucleare, come si diceva al suo debutto, è ormai un mito da seppellire.

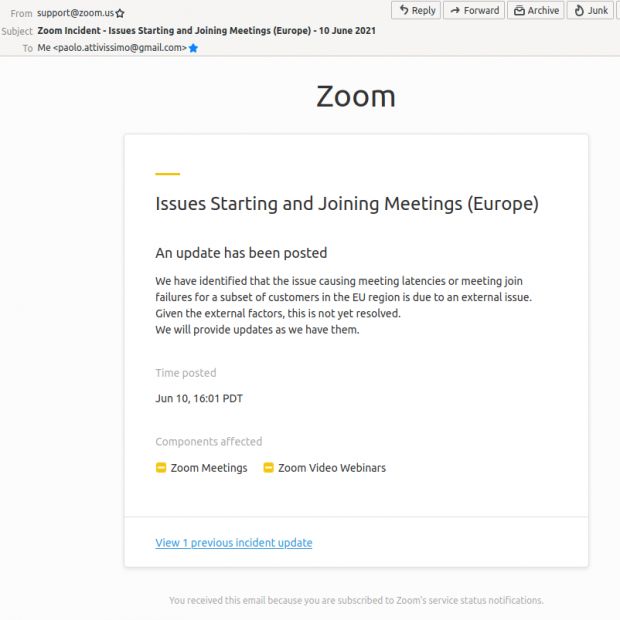

Incidenti come questo, dovuti alla dipendenza da questi fornitori, sono piuttosto frequenti anche se relativamente brevi. Nel 2017 capitò ad Amazon Web Services, che per quattro ore mise fuori uso siti come Netflix e Spotify. Nel 2019 toccò a Cloudflare, che mandò in tilt Dropbox, Discord, Medium, Soundcloud e molti altri siti frequentatissimi. E proprio l’altro giorno (10 giugno) un “aumento della temperatura ambiente” di un datacenter Amazon a Francoforte ha causato grossi problemi di connettività, nei quali sono probabilmente incappato anch’io: il webinar su Zoom che stavo coordinando è andato a gambe all’aria in diretta, lasciando scollegate alcune centinaia di partecipanti senza alcuna possibilità di riconnettersi (Zoom usa AWS).

Dalla pagina di stato di Amazon:

The root cause of this issue was a failure of a control system which disabled multiple air handlers in the affected Availability Zone. These air handlers move cool air to the servers and equipment, and when they were disabled, ambient temperatures began to rise. Servers and networking equipment in the affected Availability Zone began to power-off when unsafe temperatures were reached. Unfortunately, because this issue impacted several redundant network switches, a larger number of EC2 instances in this single Availability Zone lost network connectivity.

While our operators would normally had been able to restore cooling before impact, a fire suppression system activated inside a section of the affected Availability Zone. When this system activates, the data center is evacuated and sealed, and a chemical is dispersed to remove oxygen from the air to extinguish any fire. In order to recover the impacted instances and network equipment, we needed to wait until the fire department was able to inspect the facility. After the fire department determined that there was no fire in the data center and it was safe to return, the building needed to be re-oxygenated before it was safe for engineers to enter the facility and restore the affected networking gear and servers. The fire suppression system that activated remains disabled. This system is designed to require smoke to activate and should not have discharged. This system will remain inactive until we are able to determine what triggered it improperly. In the meantime, alternate fire suppression measures are being used to protect the data center. Once cooling was restored and the servers and network equipment was re-powered, affected instances recovered quickly. A very small number of remaining instances and volumes that were adversely affected by the increased ambient temperatures and loss of power remain unresolved.

Il collasso di martedì scorso è stato causato involontariamente da uno dei clienti di Fastly, che ha appunto cambiato le proprie impostazioni, in maniera assolutamente legittima, e così facendo ha attivato un bug che era presente in un aggiornamento software che Fastly aveva diffuso ai propri clienti a metà maggio. Il bug ha fatto sì che l’85% della rete di Fastly desse errore.

Per fortuna i tecnici di Fastly hanno capito rapidamente la causa del problema e nel giro di una cinquantina di minuti scarsi sono riusciti a rimettere in funzione il 95% della propria rete. L’azienda si è scusata e ha spiegato in parte cosa è successo in questa cronologia degli eventi e in questo rapporto.

L’unica cosa rimasta inspiegata è l’identità del cliente di Fastly che ha fatto crollare mezza Internet. Non so voi, ma se l’avessi fatto io lo metterei nel curriculum.