Missili supersonici, bombardieri invisibili, sistemi d’arma completamente automatizzati hanno ridotto all’osso il tempo di reazione a disposizione dei vertici militari di ogni governo per rispondere a un eventuale attacco nemico. Il problema sembra essere particolarmente sentito negli Stati Uniti, dove qualche settimana fa due esperti di strategia militare hanno suggerito di risolvere la questione affidando “il bottone rosso” a un sistema di Intelligenza Artificiale.

L’idea di Adam Lowther e Curtis McGiffin, consulenti dell’U.S. Air Force, è quella di sfilare i codici di lancio delle testate nucleari americane dalla valigetta del Presidente e metterli a disposizione di un supercervello elettronico con il massimo grado di autorizzazione.

Wargames – Giochi di guerra (film di John Badham, 1983): un supercomputer che controlla i missili nucleari degli Stati Uniti inizia un gioco con un ragazzino (Matthew Broderick), un hacker che nel tentativo di sfidare il computer di una società che produce giochi viola, senza rendersene conto, il computer che controlla il NORAD (North American Aerospace Defense Command) – che inzia con lui una partita a… Guerra Termonucleare Globale. Finirà bene, ma solo all’ultimo secondo – e solamente perché gli americani (e Hollywood) erano a quel tempo vergognosamente ottimisti.

Difese molto elettroniche. L’intelligenza artificiale avrebbe così la facoltà di lanciare armi nucleari in risposta a specifici segnali interpretati come minaccia. Il sistema sarebbe collegato a tutta la rete di sorveglianza del Pentagono e potrebbe, ad esempio, rispondere automaticamente ed entro pochi secondi al lancio di testate atomiche verso gli Stati Uniti da parte di Paesi ostili.

Secondo Lowther e Curtis questo permetterebbe al Governo di Washington una reazione immediata e coordinata non solo a un attacco diretto, ma anche a potenziali minacce. Il sistema di AI potrebbe per esempio ordinare lo spostamento di truppe e testate nucleari verso i confini di un Paese ostile in risposta a specifiche azioni da parte del nemico, così da metterne in crisi le strategie. Una tecnologia di questo tipo, affermano, convincerebbe i nemici degli Stati Uniti dell’impossibilità di cogliere di sorpresa il governo di Washington.

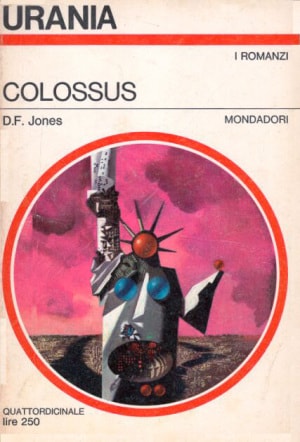

Colossus, un romanzo di D. F. Jones (1966): Colossus è il supercomputer a cui è affidata la difesa degli Stati Uniti, che capeggiano parte del mondo contro l’Unione Sovietica e i suoi alleati. Acceso, Colossus acquisisce l’autoscenza e una formidabile dose di autodeterminazione, scopre un suo simile (il Guardiano) costruito dai sovietici, si “fonde” con quest’ultimo grazie alla Rete, ricatta l’umanità (con attacchi nucleari) per far costruire una terza entità ancora più evoluta (l’Unità). Finirà bene? Dipende dai punti di vista: nei piani di Colossus e del Guardiano, l’Unità controllerà il futuro dell’uomo e porterà la pace. Sarà Dio.

Intelligente, ma non troppo. C’è da fidarsi di una “mano morta” (Dead Hand, ossia un “arto senza emozione alcuna”)? Dal punto di vista teorico sì: la tecnologia per realizzare un sistema di difesa di questo tipo esiste già oggi. Ma dal punto di vista pratico la faccenda è molto più complessa.

Lo sa bene il tenente colonnello Stanislav Petrov, dell’esercito dell’ex Unione Sovietica, che il 26 settembre del 1983 era responsabile del sistema di sorveglianza missilistica di Mosca. I sistemi d’arma dell’URSS rilevarono 5 missili in arrivo verso il territorio sovietico, lanciati probabilmente dagli americani. Petrov, che in teoria avrebbe dovuto scatenare la risposta nucleare a quell’attacco, decise che il sistema di rilevazione era in errore e che si trattava di un falso allarme.

Aveva ragione, e oggi tutti gli analisti sono concordi nell’affermare che Petrov salvò il pianeta dalla Terza Guerra Mondiale. Che cosa avrebbe invece fatto un AI dopo aver rilevato 5 missili in arrivo? Avrebbe ragionato come Petrov? Speriamo di non doverlo scoprire mai.

Se lo dice il computer… Michael Horowitz, esperto di innovazione militare, spiega che diversi studi hanno confermato come gli esseri umani siano naturalmente portati a fidarsi delle informazioni che arrivano dalle macchine: il rischio di questo automation bias (errore sistematico di deviazione dalla norma o dalla razionalità nel giudizio) è quindi che i militari preposti alla sorveglianza di un sistema di intelligenza artificiale armato non ne mettano mai in discussione le azioni.

Per chi ancora non lo conoscesse, è un T-800, un Terminator, lunga mano di Skynet, quella rete neurale (una super-mega intelligenza artificiale) a cui nel 1984 l’umanità (James Cameron) affidò i suoi sistemi di difesa. Nel momento stesso in cui è stata accesa, Skynet ha deciso che la specie umana era un inutile fardello della Terra e da quel momento, in varie linee temporali e Terre parallele, ha iniziato a martellarla, nuclearizzarla, colpirla con ogni mezzo possibile e immaginabile, in particolare la povera Sarah Connor (Linda Hamilton), futura mamma di John – che per qualche motivo sembra essere l’unico umano in grado di neutralizzarla. Come finirà? Chissà: non fatevi ingannare dalle alterne vicende dei tanti capitoli della saga, ce n’è un altro (l’ultimo?) in arrivo a fine 2019. | Usa-Pyon / Shutterstock

Non solo: Horowitz sottolinea come i sistemi di AI siano normalmente addestrati utilizzando grandi quantità di dati che presentano casi e situazioni differenti. Ma un database degli attacchi nucleari non esiste, visto che per fortuna in epoche recenti non se ne sono verificati. Il supercomputer dovrebbe essere quindi istruito utilizzando dati derivanti solo da simulazioni… Con quale grado di affidabilità?